يشعر العديد من المستخدمين بالقلق إزاء ما يحدث لبياناتهم عند استخدام chatbots AI المستندة إلى مجموعة النظراء مثل ChatGPT أو Gemini أو Deepseek. في حين أن بعض الاشتراكات تدعي أنها تمنع الموفر من استخدام البيانات الشخصية التي تم إدخالها في chatbot ، من يعرف ما إذا كانت هذه المصطلحات تقف حقًا. تحتاج أيضًا إلى اتصال إنترنت مستقر وسريع لاستخدام Cloud AI. ولكن إذا لم يكن هناك اتصال بالإنترنت ، فماذا إذن؟ حسنًا ، هناك دائمًا بديل.

أحد الحلول هو تشغيل تطبيقات الذكاء الاصطناعي محليًا. ومع ذلك ، فإن هذا يتطلب من الكمبيوتر أو الكمبيوتر المحمول أن يكون لديه كمية مناسبة من قوة المعالجة. هناك أيضًا عدد متزايد من التطبيقات القياسية التي تعتمد على الذكاء الاصطناعي الآن. ولكن إذا تم تحسين أجهزة الكمبيوتر المحمول لاستخدام الذكاء الاصطناعي ، فيمكنك العمل بشكل أسرع وأكثر فعالية مع تطبيقات الذكاء الاصطناعي.

مزيد من القراءة: “ترميز” تطبيقاتك الخاصة مع الذكاء الاصطناعى سهلة! 7 أدوات وحيل للبدء

العمل مع تطبيقات الذكاء الاصطناعي المحلي أمر منطقي

تشغيل تطبيقات الذكاء الاصطناعى محليًا لا يقلل فقط من الاعتماد على المنصات الخارجية ، ولكنه يخلق أيضًا أساسًا موثوقًا بحماية البيانات وسيادة البيانات والموثوقية. خاصة في الشركات الصغيرة التي لديها معلومات حساسة للعميل أو في الأسر الخاصة ذات البيانات الشخصية ، يزيد الاستخدام المحلي لمنظمة العفو الدولية من الثقة. لا يزال الذكاء الاصطناعى المحلي قابلاً للاستخدام حتى إذا تعطلت خدمات الإنترنت أو تعاني مزود السحابة من مشاكل فنية.

تتحسن سرعة التفاعل بشكل كبير حيث لا يتم إبطاء عمليات الحوسبة في أوقات الكمون. يتيح ذلك استخدام نماذج الذكاء الاصطناعى في سيناريوهات الوقت الفعلي مثل التعرف على الصور أو توليد النص أو التحكم الصوتي دون تأخير.

ما هو أكثر من ذلك ، يمكنك تعلم كيفية استخدام الذكاء الاصطناعى مجانًا تمامًا. في كثير من الحالات ، يتوفر البرنامج اللازم مجانًا تمامًا كحل مفتوح المصدر. تعرف على كيفية استخدام الذكاء الاصطناعي مع الأدوات والاستفادة من استخدام الأبحاث المدعومة من الذكاء الاصطناعي في حياتك الخاصة أيضًا.

لماذا يجعل NPU الفرق

بدون NPU متخصصة ، حتى دفاتر الملاحظات الحديثة تصل بسرعة إلى حدودها في تطبيقات الذكاء الاصطناعي. تتطلب نماذج اللغة ومعالجة الصور قوة حوسبة هائلة تغلب على الأجهزة التقليدية. ينتج عن هذا أوقات تحميل طويلة ، وعمليات بطيئة وخفض عمر البطارية بشكل كبير. هذا هو بالضبط حيث تدخل ميزة NPU متكاملة في اللعب.

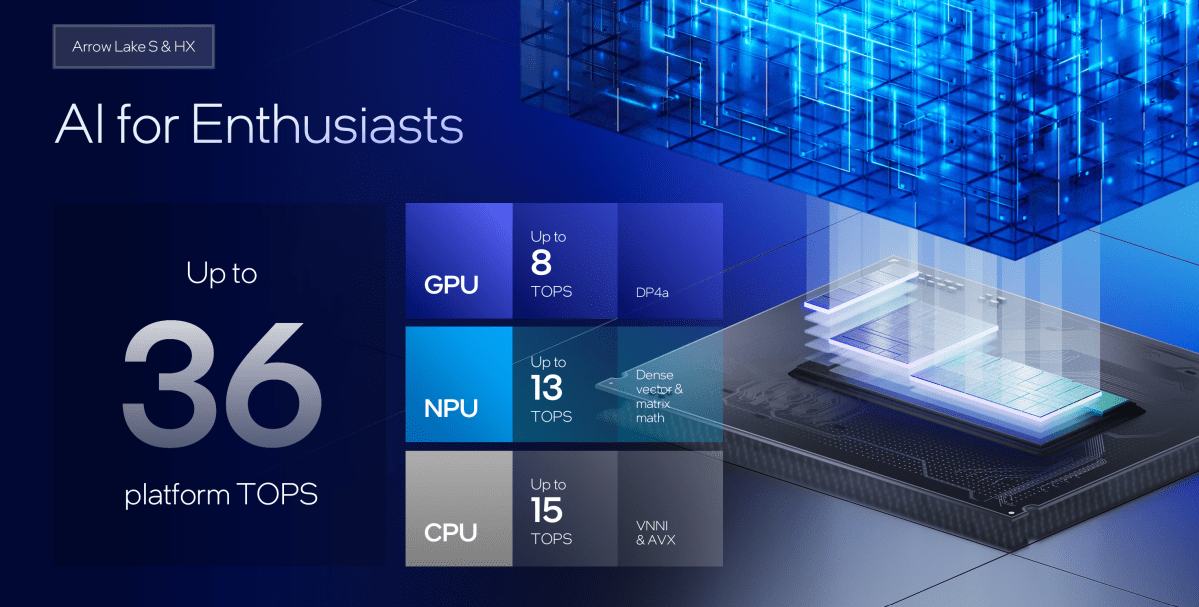

يتعامل NPU مع الأجزاء المكثفة من الناحية الحسابية لمعالجة الذكاء الاصطناعي بشكل مستقل ولا تعتمد على وحدة المعالجة المركزية أو وحدة معالجة الرسومات. نتيجة لذلك ، يظل النظام مستجيبًا بشكل عام ، حتى إذا كانت خدمة الذكاء الاصطناعى تعمل في الخلفية أو أن معالجة صور الذكاء الاصطناعى قيد التقدم. في الوقت نفسه ، تظل درجة حرارة التشغيل منخفضة ، ويظل المشجعون هادئين ويتم تشغيل الجهاز بشكل ثابت ، حتى في التشغيل المستمر. بالنسبة لتطبيقات الذكاء الاصطناعى المحلي ، فإن NPU ليس إضافة ، ولكنه شرط أساسي للأداء السلس والقابل للاستخدام.

NPUs تسريع بشكل كبير منظمة العفو الدولية محليا مرة أخرى

بصفته مسرعات منظمة العفو الدولية المتخصصة ، تمكن NPUs من النماذج المكثفة حسابيًا لكفاءة على الأجهزة النهائية القياسية. هذا يقلل من استهلاك الطاقة مقارنةً بالمناهج القائمة على وحدة المعالجة المركزية أو GPU ويجعل منظمة العفو الدولية محلية مثيرة للاهتمام في المقام الأول.

NPU هي شريحة خاصة لتسريع المهام حيث تعمل المعالجات التقليدية بشكل غير فعال. تعني NPU “وحدة المعالجة العصبية”. يتم استخدام هذه الشبكات في نماذج اللغة أو التعرف على الصور أو مساعدي الذكاء الاصطناعي. على عكس وحدة المعالجة المركزية ، التي تنفذ برامج مختلفة بمرونة ، تركز NPU على الحسابات التي يتم تنفيذها باستمرار في مجال الذكاء الاصطناعي. هذا يسمح لها بالعمل بشكل أسرع وأكثر اقتصادا.

يأخذ NPU على وجه التحديد تلك المهام حيث تصل وحدة المعالجة المركزية إلى حدودها. يتم حساب تطبيقات الذكاء الاصطناعي مع عدد كبير من الأرقام في نفس الوقت ، وغالبًا ما يكون في شكل مصفوفات. هذه هي جداول الأرقام مع الصفوف والأعمدة. في الذكاء الاصطناعى ، فإنها تساعد على هيكلة وحساب كميات كبيرة من البيانات. يتم تحويل النصوص أو الصور أو اللغة إلى أرقام وتمثيلها كمصفوفات. هذا يتيح نموذج الذكاء الاصطناعي من إجراء عمليات الحوسبة بكفاءة.

تم تصميم NPUs لمعالجة العديد من هذه المصفوفات في وقت واحد. تقوم وحدة المعالجة المركزية بمعالجة مثل هذه الأنماط الحسابية واحدة تلو الأخرى ، والتي تكلف الوقت والطاقة. من ناحية أخرى ، تم تصميم NPU خصيصًا لتنفيذ العديد من هذه العمليات بالتوازي.

بالنسبة للمستخدمين ، هذا يعني أن NPU يعالج مهام الذكاء الاصطناعي مثل إدخال الصوت أو التعرف على الكائنات أو توليد النص التلقائي بشكل أسرع وأكثر كفاءة. وفي الوقت نفسه ، تظل وحدة المعالجة المركزية مجانية للمهام الأخرى مثل نظام التشغيل أو متصفح الإنترنت أو تطبيقات المكاتب. هذا يضمن تجربة مستخدم سلسة دون تأخير أو استهلاك الطاقة العالية. الأجهزة الحديثة مثل أجهزة الكمبيوتر المحمولة مع Intel Core Ultra أو Qualcomm Snapdragon X Elite تدمج بالفعل NPUs الخاصة بها. تستخدم Apple أيضًا تقنية مماثلة في رقائقها لسنوات (Apple Silicon M1 إلى M4).

يتم تشغيل التطبيقات المدعومة من الذكاء الاصطناعي محليًا وتتفاعل بسرعة دون نقل البيانات إلى الخوادم السحابية. يضمن NPU التشغيل السلس لمعالجة الصور أو التعرف على النص أو النسخ أو الإدخال الصوتي أو الاقتراحات الشخصية. في الوقت نفسه ، فإنه يقلل من استخدام النظام ويوفر طاقة البطارية. لذلك ، من المفيد اختيار أجهزة الكمبيوتر المحمولة مع شريحة NPU ، خاصة إذا كنت تعمل مع حلول الذكاء الاصطناعي. هذه لا يجب أن تكون chatbots منظمة العفو الدولية. تستخدم المزيد والمزيد من التطبيقات والألعاب المحلية الذكاء الاصطناعي ، وحتى Windows 11 نفسها.

المصدر المفتوح يجلب الذكاء الاصطناعي محليًا على جهاز الكمبيوتر الخاص بك: Ollama وفتح ويب واجهة المستخدم

تتيح لك حلول المصدر المفتوح مثل Ollama تشغيل LLMs على دفتر ملاحظات مع رقاقة NPU مجانًا. LLM تعني “نموذج اللغة الكبيرة”. LLMs تشكل قلب تطبيقات الذكاء الاصطناعي. أنها تمكن أجهزة الكمبيوتر من فهم اللغة الطبيعية والرد عليها بطريقة ذات مغزى.

أي شخص يستخدم منظمة العفو الدولية لكتابة نصوص أو تلخيص رسائل البريد الإلكتروني أو الإجابة على الأسئلة تتفاعل مع LLM. تساعد نماذج AI في صياغة أو شرح أو ترجمة أو تصحيح. تستخدم محركات البحث ومساعدي اللغة ومحرري النص الذكي أيضًا LLMs في الخلفية. العامل الحاسم هنا ليس فقط أداء النموذج ، ولكن أيضًا حيث يعمل. إذا قمت بتشغيل LLM محليًا ، فيمكنك توصيل تطبيقات AI المحلية بهذا النموذج المحلي. هذا يعني أنك لم تعد تعتمد على الإنترنت.

يتيح Ollama تشغيل العديد من LLMs ، بما في ذلك تلك الحرة. وتشمل هذه Deepseek-R1 و Qwen 3 و Llama 3.3 والعديد من الآخرين. يمكنك ببساطة تثبيت Ollama على جهاز الكمبيوتر أو الكمبيوتر المحمول باستخدام Windows و Linux و MacOS. بمجرد التثبيت ، يمكنك تشغيل Ollama عبر سطر الأوامر في Windows أو المحطة في MacOS و Linux. يوفر Ollama الإطار الذي يمكنك من خلاله تثبيت LLMs المختلفة على جهاز الكمبيوتر الخاص بك أو دفتر الملاحظات.

للعمل مع Ollama بنفس الطريقة التي اعتدت بها مع تطبيقات AI مثل ChatGPT أو Gemini أو Microsoft Copilot ، تحتاج أيضًا إلى نهاية أمامية على شبكة الإنترنت. هنا يمكنك الاعتماد على حل OpenWeb واجهة المستخدم ، وهو أيضًا مجاني. هذا متاح أيضًا كأداة مجانية ومفتوحة المصدر.

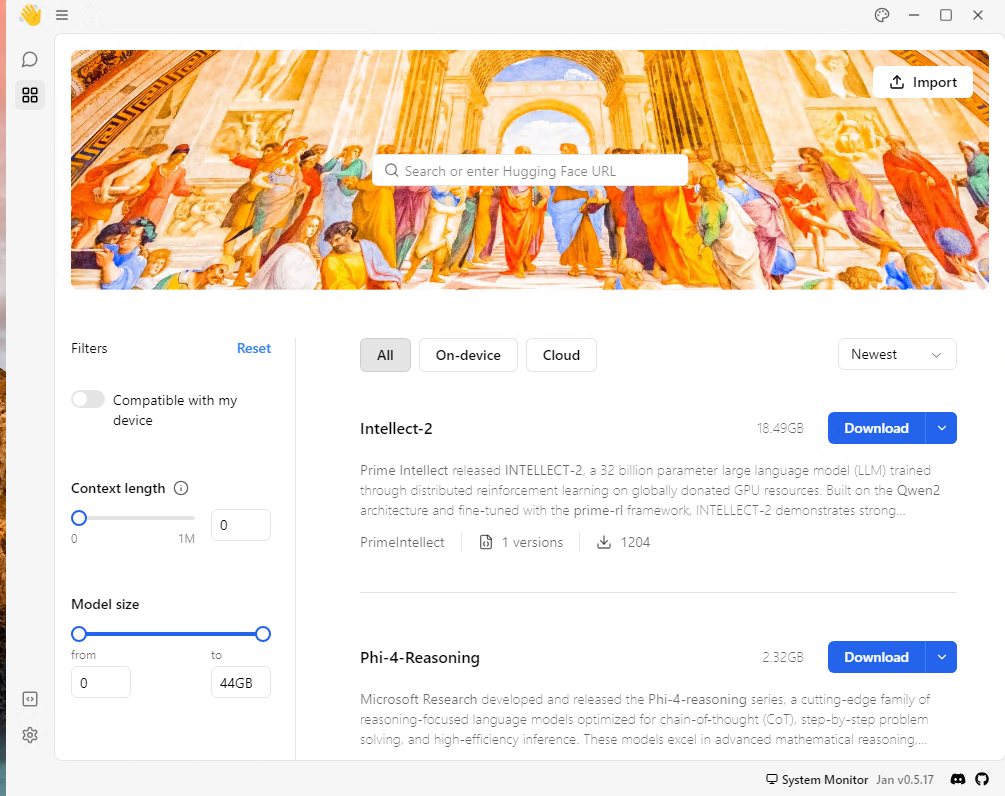

كبديل لـ Ollama مع واجهة مستخدم الويب المفتوحة ، يمكنك أيضًا استخدام أداة GPT4All الأكثر محدودة. خيار آخر في هذا المجال هو Jan.ai ، والذي يوفر الوصول إلى LLMs المعروفة مثل Deepseek-R1 أو Claude 3.7 أو GPT 4 من Openai. للقيام بذلك ، قم بتثبيت Jan.ai ، وابدأ البرنامج ، وحدد LLM المطلوب.

ومع ذلك ، يرجى ملاحظة أن تنزيلات النموذج يمكن أن تصل بسرعة إلى 20 جيجابايت أو أكثر. بالإضافة إلى ذلك ، من المنطقي استخدامها فقط إذا تم تحسين أجهزة جهاز الكمبيوتر الخاص بك من أجل الذكاء الاصطناعي ، بشكل مثالي مع NPU موجود.

ظهرت هذه المقالة في الأصل على PC-WELT Sister Publication وتم ترجمتها وتوطينها من الألمانية.