أطلقت Nvidia Dynamo ، وهو برنامج استدلال مفتوح المصدر مصمم لتسريع وتوسيع نطاق نماذج التفكير داخل مصانع الذكاء الاصطناعي.

إن إدارة وتنسيق طلبات الاستدلال من الذكاء الاصطناعى بكفاءة عبر أسطول من وحدات معالجة الرسومات هي مسعى حاسم لضمان أن مصانع الذكاء الاصطناعى يمكن أن تعمل بفعالية من حيث التكلفة المثلى وزيادة توليد الإيرادات الرمزية.

مع انتشار منطق الذكاء الاصطناعي بشكل متزايد ، من المتوقع أن يولد كل نموذج منظمة العفو الدولية عشرات الآلاف من الرموز مع كل موجه ، ويمثل بشكل أساسي عملية “التفكير”. وبالتالي فإن تعزيز أداء الاستدلال مع تقليل تكلفته في وقت واحد أمر بالغ الأهمية لتسريع النمو وزيادة فرص الإيرادات لمقدمي الخدمات.

جيل جديد من برامج الاستدلال الذكاء الاصطناعى

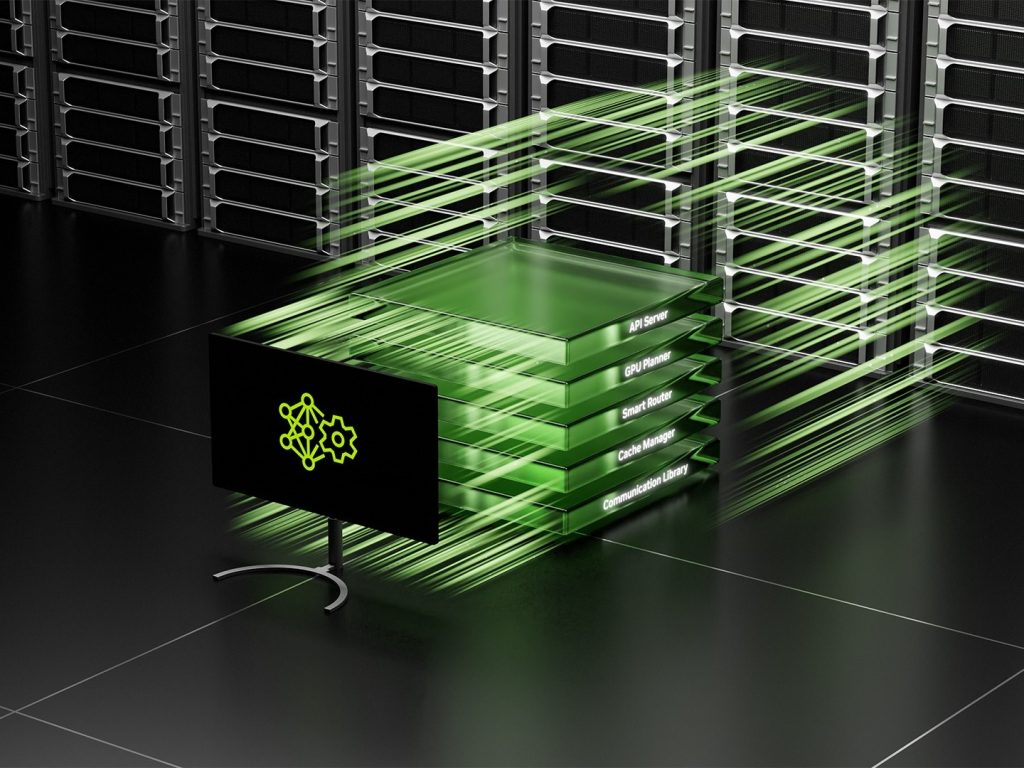

يمثل Nvidia Dynamo ، الذي ينجح خادم الاستدلال Nvidia Triton ، جيلًا جديدًا من برامج الاستدلال من الذكاء الاصطناعى المصمم خصيصًا لزيادة توليد الإيرادات الرمزية لمصانع الذكاء الاصطناعى التي تنشر نماذج الذكاء الاصطناعي.

يقوم Dynamo بتنسيق التواصل الاستنتاجي ويسرع عبر الآلاف من وحدات معالجة الرسومات. توظف الخدمة المفككة ، وهي تقنية تفصل بين مراحل المعالجة والتوليد من نماذج اللغة الكبيرة (LLMS) على وحدات معالجة الرسومات المميزة. يتيح هذا النهج تحسين كل مرحلة بشكل مستقل ، وتلبية احتياجاتها الحسابية المحددة وضمان الاستخدام القصوى لموارد GPU.

“إن الصناعات في جميع أنحاء العالم تدرب نماذج منظمة العفو الدولية على التفكير والتعلم بطرق مختلفة ، مما يجعلها أكثر تطوراً مع مرور الوقت” ، صرح جنسن هوانغ ، مؤسس ومدير التنفيذي لشركة NVIDIA. “لتمكين مستقبل المنطق المخصص لمنظمة العفو الدولية ، يساعد Nvidia Dynamo في خدمة هذه النماذج على نطاق واسع ، مما يؤدي إلى وفورات في التكاليف والكفاءات عبر مصانع الذكاء الاصطناعي.”

باستخدام نفس العدد من وحدات معالجة الرسومات ، أظهر Dynamo القدرة على مضاعفة أداء وإيرادات مصانع الذكاء الاصطناعى التي تخدم نماذج Llama على منصة النطاط الحالية في Nvidia. علاوة على ذلك ، عند تشغيل نموذج Deepseek-R1 على مجموعة كبيرة من رفوف GB200 NVL72 ، أظهرت تحسينات الاستدلال الذكي لـ NVIDIA DYNAMO زيادة عدد الرموز التي تم إنشاؤها بأكثر من 30 مرة لكل وحدة معالجة الرسومات.

لتحقيق هذه التحسينات في أداء الاستدلال ، تتضمن Nvidia Dynamo العديد من الميزات الرئيسية المصممة لزيادة الإنتاجية وتقليل تكاليف التشغيل.

يمكن لـ Dynamo إضافة وحدات معالجة الرسومات الديناميكية وإعادة تخصيصها في الوقت الفعلي للتكيف مع أحجام وأنواع الطلبات المتقلبة. يمكن للبرنامج أيضًا تحديد وحدات معالجة الرسومات المحددة في مجموعات كبيرة مناسبة لتقليل حسابات الاستجابة إلى الحد الأدنى ومستعلات المسار بكفاءة. يمكن لـ Dynamo أيضًا إلغاء تحميل بيانات الاستدلال إلى أجهزة ذاكرة وأجهزة تخزين أكثر فعالية من حيث التكلفة مع استردادها بسرعة عند الحاجة ، وبالتالي تقليل تكاليف الاستدلال الإجمالية.

يتم إصدار Nvidia Dynamo كمشروع مفتوح المصدر بالكامل ، ويوفر توافقًا واسعًا مع الأطر الشهيرة مثل Pytorch و Sglang و Nvidia Tensorrt-Llm و VLLM. يدعم هذا النهج المفتوح المؤسسات والشركات الناشئة والباحثين في تطوير وتحسين الأساليب الجديدة لخدمة نماذج الذكاء الاصطناعى عبر البنية التحتية المتنوعة.

تتوقع Nvidia أن يسرع Dynamo اعتماد استدلال الذكاء الاصطناعي عبر مجموعة واسعة من المنظمات ، بما في ذلك مقدمي الخدمات السحابية الرئيسية ومبتكري الذكاء الاصطناعى مثل AWS و Cohere و CoreWeave و Dell و Fireworks و Google Cloud و Lambda و Meta و Microsoft Azure و Nebius و Netapp و Oci و Oci و Oci و Oci ، و Oci ،

Nvidia Dynamo: الاستدلال الفائق والوكيل الذكاء الاصطناعي

يكمن الابتكار الرئيسي لـ Nvidia Dynamo في قدرتها على تعيين المعرفة التي تحملها أنظمة الاستدلال في الذاكرة من تقديم الطلبات السابقة ، والمعروفة باسم ذاكرة التخزين المؤقت KV ، عبر الآلاف من وحدات معالجة الرسومات.

يقوم البرنامج بعد ذلك بذكاء بتوجيه طلبات الاستدلال الجديدة إلى وحدات معالجة الرسومات التي تمتلك أفضل مطابقة للمعرفة ، وتجنب عمليات إعادة الحسابات المكلفة بشكل فعال وتحرير وحدات معالجة الرسومات الأخرى للتعامل مع طلبات جديدة واردة. آلية التوجيه الذكية هذه تعزز بشكل كبير الكفاءة وتقلل زمن انتقال.

وقال دينيس يارات ، CTO من الذكاء الاصطناعي ، “للتعامل مع مئات الملايين من الطلبات شهريًا ، نعتمد على Nvidia GPU وبرامج الاستدلال لتقديم الأداء والموثوقية وتوسيع نطاق طلبنا من أعمالنا والمستخدمين”.

“نتطلع إلى الاستفادة من Dynamo ، من خلال إمكانيات التقديم الموزعة المعززة ، لدفع المزيد من الكفاءة التي تخدم الاستدلال وتلبية متطلبات الحساب لنماذج التفكير المنطقية الجديدة.”

تخطط منصة AI Cohere بالفعل للاستفادة من Nvidia Dynamo لتعزيز قدرات AI Agentic ضمن سلسلة أوامر النماذج.

“يتطلب توسيع نطاق نماذج الذكاء الاصطناعى المتقدمة جدولة متعددة GPU متطورة ، والتنسيق السلس ومكتبات الاتصالات المنخفضة الكلية التي تنقل سياقات التفكير بسلاسة عبر الذاكرة والتخزين” ، أوضح سوراب باجي ، SVP للهندسة في Cohere.

“نتوقع أن تساعدنا Nvidia Dynamo في تقديم تجربة مستخدم رئيسية لعملائنا في المؤسسات.”

الدعم للخدمة المفككة

تتميز منصة استدلال NVIDIA DYNAMO أيضًا بدعم قوي للخدمة غير المتجددة. تقوم هذه التقنية المتقدمة بتعيين المراحل الحسابية المختلفة لـ LLMS – بما في ذلك الخطوات الحاسمة لفهم استعلام المستخدم ثم إنشاء الاستجابة الأنسب – إلى وحدات معالجة الرسومات المختلفة داخل البنية التحتية.

إن التقديم غير المتجنب مناسب بشكل خاص لنماذج التفكير ، مثل عائلة نموذج NVIDIA Llama Nemotron الجديدة ، والتي تستخدم تقنيات الاستدلال المتقدمة لتحسين الفهم السياقي وتوليد الاستجابة. من خلال السماح لكل مرحلة أن يتم ضبطه وموارده بشكل مستقل ، فإن التقديم غير المتجنب يحسن الإنتاجية بشكل عام وتوفر أوقات استجابة أسرع للمستخدمين.

معا من الذكاء الاصطناعى ، لاعب بارز في مساحة سحابة AI Acceleration Cloud ، يتطلع أيضًا إلى دمج محرك الاستدلال الخاص به مع Nvidia Dynamo. يهدف هذا التكامل إلى تمكين التحجيم السلس لأعباء عمل الاستدلال عبر عقد GPU المتعددة. علاوة على ذلك ، سوف يسمح معًا AI بمعالجة اختناقات حركة المرور التي قد تنشأ في مراحل مختلفة من خط أنابيب النموذج.

“إن توسيع نطاق نماذج التفكير يتطلب بفعالية تقنيات الاستدلال المتقدمة الجديدة ، بما في ذلك التوجيه المفكك والتعرف على السياق” ، صرح Ce Zhang ، CTO من AI معًا.

“سوف يتيح لنا الانفتاح على NVIDIA DYNAMO سد مكوناتها بسلاسة في محركنا لخدمة المزيد من الطلبات مع تحسين استخدام الموارد-مما يجعل استثماراتنا الحاسوبية المتسارعة.

أربعة ابتكارات رئيسية لـ Nvidia Dynamo

سلطت NVIDIA الضوء على أربعة ابتكارات رئيسية داخل DYNAMO تساهم في تقليل تكاليف خدمة الاستدلال وتعزيز تجربة المستخدم الإجمالية:

- مخطط GPU: محرك التخطيط المتطور الذي يضيف بشكل ديناميكي ويزيل وحدات معالجة الرسومات بناءً على طلب المستخدم المتذبذب. وهذا يضمن تخصيص الموارد الأمثل ، مما يمنع كل من الإفراط في تقديم وسعة وحدة معالجة الرسومات.

- جهاز التوجيه الذكي: جهاز توجيه ذكي على دراية LLM يوجه طلبات الاستدلال عبر أساطيل كبيرة من وحدات معالجة الرسومات. تتمثل وظيفتها الأساسية في تقليل عمليات إعادة حساب GPU المكلفة لطلبات التكرار أو المتداخلة ، وبالتالي تحرير موارد GPU القيمة للتعامل مع الطلبات الواردة الجديدة بشكل أكثر كفاءة.

- مكتبة الاتصالات المنخفضة لتكليف: مكتبة محسّنة للاستدلال مصممة لدعم اتصالات GPU-to-GPU الحديثة. إنه يجرّب تعقيدات تبادل البيانات عبر الأجهزة غير المتجانسة ، مما يتسارع بشكل كبير سرعات نقل البيانات.

- مدير الذاكرة: محرك ذكي يدير تفريغ بيانات الاستدلال وإعادة تحميلها من وإلى أجهزة الذاكرة والأجهزة التخزين المنخفضة التكلفة. تم تصميم هذه العملية لتكون سلسة ، مما يضمن عدم وجود تأثير سلبي على تجربة المستخدم.

سيتم توفير NVIDIA DYNAMO في NIM Microservices وسيتم دعمها في إصدار مستقبلي من منصة برنامج AI Enterprise التابعة للشركة.

انظر أيضا: LG Exaone Deep هو برتقالي للرياضيات والعلوم والترميز

هل تريد معرفة المزيد عن الذكاء الاصطناعي والبيانات الكبيرة من قادة الصناعة؟ تحقق من AI و Big Data Expo الذي يقام في أمستردام ، كاليفورنيا ، ولندن. تم تحديد الحدث الشامل مع الأحداث الرائدة الأخرى بما في ذلك مؤتمر الأتمتة الذكي ، و blockx ، وأسبوع التحول الرقمي ، ومعرض Cyber Security & Cloud.

استكشاف أحداث وندوات الويب القادمة الأخرى التي تعمل بها TechForge هنا.