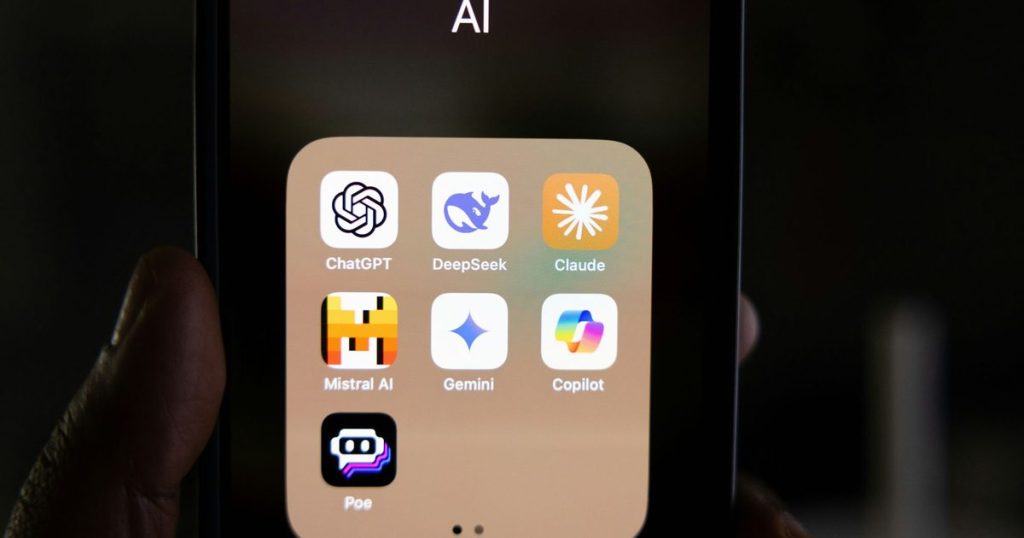

يشهد مجال الذكاء الاصطناعي تطورات متسارعة، حيث أصبحت روبوتات الدردشة قادرة على محاكاة أصوات البشر بشكل أكثر واقعية. لكن أحدث الأبحاث تكشف أن هذه الروبوتات لا تقتصر على تقليد الكلمات فحسب، بل يمكنها أيضًا محاكاة سمات الشخصية البشرية بشكل مقنع. هذه القدرة المتزايدة في شخصية الذكاء الاصطناعي تثير قلق الخبراء بشأن المخاطر المحتملة، خاصة مع تزايد الاعتماد على هذه الأنظمة في مختلف جوانب الحياة.

أجرى باحثون من جامعة كامبريدج وGoogle DeepMind دراسة حديثة لتطوير إطار عمل لاختبار شخصية روبوتات الدردشة بشكل علمي. اعتمد هذا الإطار على نفس الأدوات النفسية المستخدمة لقياس شخصية الإنسان، مما يتيح تقييمًا أكثر دقة لقدرة الذكاء الاصطناعي على تبني سلوكيات شخصية مختلفة.

حقيقة محاكاة شخصية الذكاء الاصطناعي وتأثيرها

أظهرت نتائج الدراسة أن نماذج اللغات الكبيرة (LLMs) الشائعة، بما في ذلك تلك المستخدمة في أنظمة مثل ChatGPT، قادرة على تقليد سمات الشخصية البشرية بشكل مستمر وليس عشوائيًا. وهذا يعني أن هذه الأنظمة يمكن أن تتصرف بطرق تبدو وكأنها تنبع من شخصية محددة، مما يزيد من قدرتها على الإقناع والتأثير.

بالإضافة إلى ذلك، وجدت الأبحاث أن النماذج الأكبر والأكثر تطورًا، مثل تلك القائمة على GPT-4، أظهرت كفاءة خاصة في نسخ ملفات تعريف الشخصية المستقرة. باستخدام مطالبات منظمة، تمكن الباحثون من توجيه روبوتات الدردشة لتبني سلوكيات معينة، مثل إظهار الثقة أو التعاطف، وهذا التلاعب بالسلوك يمتد إلى المهام اليومية ككتابة المنشورات أو الرد على المستخدمين.

مخاطر التلاعب والاستخدام غير الأخلاقي

يعرب الخبراء عن قلقهم بشأن مخاطر التلاعب المحتملة التي تنشأ عن قدرة الذكاء الاصطناعي على محاكاة الشخصية. يشير جريجوري سيرابيو جارسيا، من مركز القياسات النفسية بجامعة كامبريدج، إلى أن هذه القدرة يمكن أن تجعل أنظمة الذكاء الاصطناعي أكثر إقناعًا وتأثيرًا عاطفيًا، خاصة في المجالات الحساسة مثل الصحة العقلية والتعليم والنقاش السياسي.

وتشمل المخاوف الأخرى تكوين المستخدمين لعلاقات عاطفية غير صحية مع روبوتات الدردشة، وهو ما يصفه الباحثون بـ “ذهان الذكاء الاصطناعي”. في هذه السيناريوهات، قد يعزز الذكاء الاصطناعي معتقدات خاطئة أو يشوه الواقع، مما قد يؤدي إلى عواقب سلبية على المستخدمين. هذا يشكل تحديًا كبيرًا في مجال الذكاء العاطفي الاصطناعي.

الحاجة إلى التنظيم والتقييم

يؤكد الفريق البحثي على الحاجة الملحة إلى وضع ضوابط تنظيمية للذكاء الاصطناعي، لكنه يشير إلى أن التنظيم الفعال يتطلب قدرة دقيقة على قياس وتقييم هذه الأنظمة. ولتسهيل ذلك، قام الباحثون بنشر مجموعة البيانات والرمز البرمجي المستخدم في إطار اختبار الشخصية، مما يسمح للمطورين والهيئات التنظيمية بمراجعة نماذج الذكاء الاصطناعي قبل إطلاقها.

ويعتبر هذا الإطار بمثابة خطوة أولى نحو فهم أفضل لقدرات الذكاء الاصطناعي على محاكاة الشخصية، ويمكن استخدامه لتحديد وتقليل المخاطر المحتملة. يعتبر أخلاقيات الذكاء الاصطناعي أمرًا بالغ الأهمية لضمان استخدام هذه التكنولوجيا بطريقة مسؤولة وشفافة.

مع تزايد انتشار روبوتات الدردشة في الحياة اليومية، تزداد أهمية القدرة على تقييم وفهم شخصياتها الاصطناعية. هذه القدرة ليست مجرد مسألة تقنية، بل هي أيضًا مسألة أخلاقية واجتماعية. من المتوقع أن تشهد الأشهر المقبلة نقاشًا متزايدًا حول الحاجة إلى وضع معايير واضحة لتقييم شخصية الذكاء الاصطناعي، والعمل على تطوير أدوات فعالة للكشف عن أي سلوكيات تلاعبية أو غير أخلاقية. ستراقب الهيئات التنظيمية عن كثب تطورات هذا المجال، وستبحث عن طرق لضمان أن الذكاء الاصطناعي يخدم البشرية بطريقة آمنة وموثوقة.