أعلنت إنفيديا في مؤتمر GTC 2024 المنصة البرمجية الجديدة المصممة لتبسيط نشر نماذج الذكاء الاصطناعي المخصصة والمدربة سابقًا في بيئات الإنتاج NIM.

وتأخذ NIM العمل البرمجي الذي نفذته إنفيديا بخصوص الاستدلال وتحسين النماذج وتجعل الوصول إليه سهلًا من خلال الجمع بين نموذج معين ومحرك الاستدلال المحسن ومن ثم تجميعهما في حزمة، مما يجعلها متاحة بصفتها خدمة صغيرة.

ويستغرق الأمر عادةً من المطورين أسابيع وأشهر لإطلاق حزم مماثلة في حال كان لدى الشركة فريق داخلي في مجال الذكاء الاصطناعي.

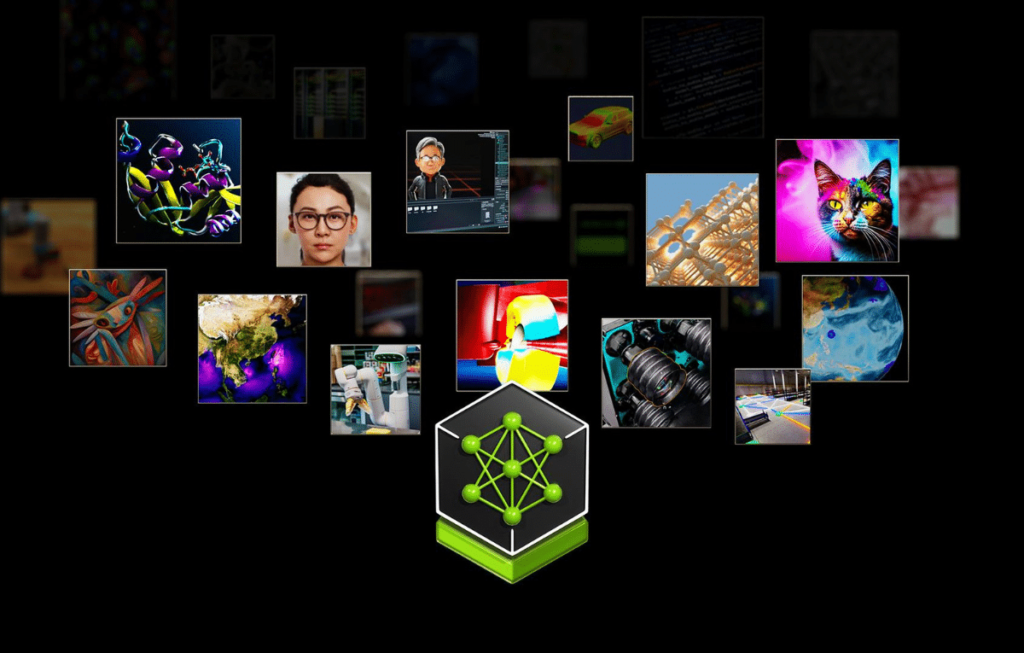

وتهدف إنفيديا من خلال NIM إلى إنشاء نظام بيئي للحزم الجاهزة للذكاء الاصطناعي التي تستخدم أجهزتها بصفتها طبقة أساسية مع هذه الخدمات الصغيرة المنسقة بصفتها طبقة البرامج الأساسية للشركات التي ترغب في تسريع خريطة طريق الذكاء الاصطناعي.

وتتضمن NIM حاليًا دعمًا لنماذج من إنفيديا A121 و Adept و Cohere و Getty Images و Shutterstock بالإضافة إلى النماذج المفتوحة من جوجل وميتا ومايكروسوفت وميسترال و Hugging Face و Stability AI.

وتعمل إنفيديا مع جوجل ومايكروسوفت وأمازون لإتاحة خدمات NIM الصغيرة هذه عبر SageMaker و Kubernetes Engine و Azure AI، مع إدماجها في أطر عمل، مثل Deepset و LangChain و LlamaIndex.

وقال مانوفير داس، رئيس قسم الحوسبة المؤسسية في إنفيديا: “نعتقد أن وحدة معالجة الرسومات من إنفيديا هي المكان الأفضل لإجراء الاستدلال على هذه النماذج، ونعتقد أن NIM هي أفضل حزمة برامج للمطورين من أجل البناء عليها حتى يتمكنوا من التركيز على تطبيقات المؤسسة”.

وتستخدم إنفيديا خوادم الاستدلال Triton و TensorRT و TensorRT-LLM لمحرك الاستدلال. وتشمل بعض خدمات إنفيديا الصغيرة المتاحة من خلال NIM خدمة تخصيص نماذج الكلام والترجمة Riva وخدمة تحسين التوجيه cuOpt وخدمة محاكاة الطقس والمناخ Earth-2.

وتخطط الشركة لإضافة إمكانات إضافية بمرور الوقت، ويشمل ذلك إتاحة مشغل النموذج اللغوي الكبير لاسترجاع الجيل المعزز RAG LLM بصفته خدمة مصغرة عبر NIM، مما يعد بتسهيل بناء روبوتات الدردشة بالذكاء الاصطناعي القادرة على سحب البيانات المخصصة.

ومن بين مستخدمي NIM الحاليين هناك أمثال Box و Cloudera و Cohesity و Datastax و Dropbox و NetApp.