أصدرت ميتا نموذجًا جديدًا للذكاء الاصطناعي يسمى V-JEPA، ويعمل هذا النموذج على تحسين فهم الآلات للعالم من خلال تحليل التفاعلات بين الأشياء في مقاطع الفيديو.

ويواصل هذا النموذج رؤية يان ليكون، نائب الرئيس ورئيس علماء الذكاء الاصطناعي في الشركة، لإنشاء ذكاء آلي يتعلم بطريقة مشابهة للبشر.

وشهد الإصدار الخامس من نموذج I-JEPA الذي أصدرته ميتا في منتصف العام الماضي تطورات فيما يتعلق بمقارنة التمثيلات المجردة للصور بدلًا من وحدات البكسل نفسها وتوسيعها لتشمل مقاطع الفيديو.

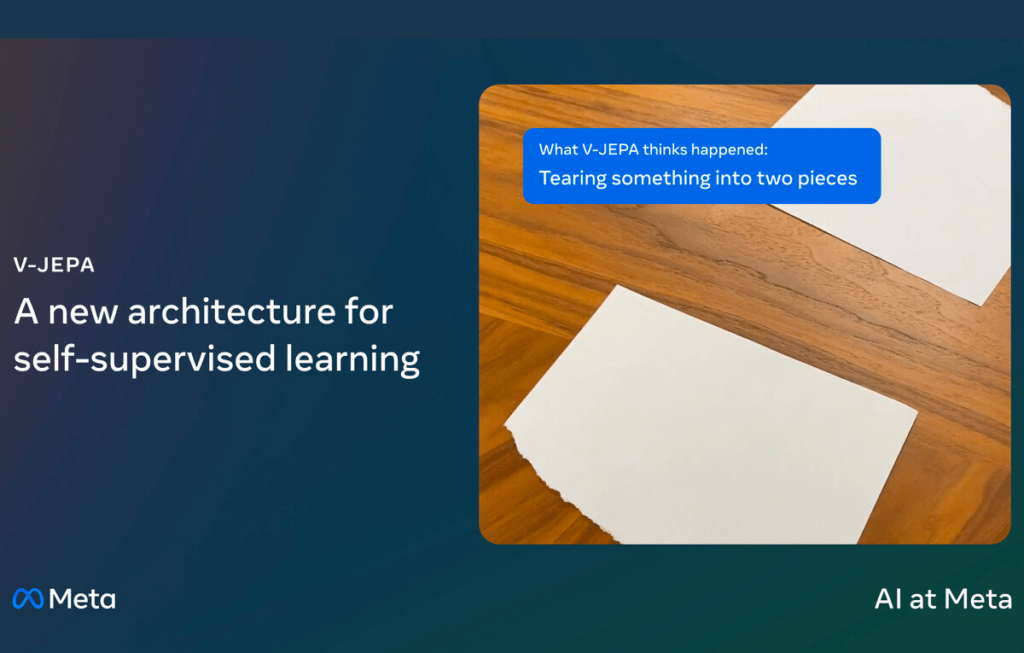

ويعمل V-JEPA على تطوير النهج التنبؤي للتعلم من الصور عبر الانتقال إلى التعلم من خلال مقاطع الفيديو، مما يقدم تعقيد الديناميكيات الزمنية المعتمدة على الوقت بالإضافة إلى المعلومات المكانية.

ويتنبأ V-JEPA بالأجزاء المفقودة من مقاطع الفيديو دون الحاجة إلى إعادة إنشاء كل التفاصيل، إذ إنه يتعلم من مقاطع فيديو غير مصنفة، مما يعني أنه لا يتطلب بيانات صنفها البشر لبدء التعلم.

وتزيد هذه الطريقة كفاءة V-JEPA، وتتطلب موارد قليلة للتدريب. ويتميز هذا النموذج بالتعلم من كمية صغيرة من المعلومات، مما يجعله سريعًا وقليل الاستهلاك للموارد مقارنة بالنماذج القديمة.

وتضمن تطوير النموذج إخفاء أجزاء كبيرة من مقاطع الفيديو، ويجبر هذا النهج V-JEPA على إجراء التخمينات بناءً على سياق محدود، مما يساعده في فهم السيناريوهات المعقدة دون الحاجة إلى بيانات مفصلة.

ويركز V-JEPA على الفكرة العامة لما يحدث في الفيديو بدلًا من التفاصيل المحددة، مثل حركة الأوراق الفردية على الشجرة.

وأظهر V-JEPA نتائج واعدة في الاختبارات، إذ تفوق على نماذج تحليل الفيديو الأخرى باستخدام جزء صغير من البيانات المطلوبة عادةً.

وينظر إلى هذه الكفاءة على أنها خطوة إلى الأمام في مجال الذكاء الاصطناعي، مما يجعل من الممكن استخدام النموذج في مهام مختلفة دون إعادة تدريب واسعة النطاق.

وتخطط ميتا في المستقبل لتوسيع قدرات V-JEPA، ويشمل ذلك إضافة التحليل الصوتي وتحسين قدرته في فهم مقاطع الفيديو الطويلة.

ويدعم هذا العمل هدف ميتا الواسع المتمثل في تطوير الذكاء الآلي من أجل أداء مهام معقدة مثل البشر.

ويتاح V-JEPA بموجب ترخيص المشاع الإبداعي غير التجاري، مما يسمح للباحثين في جميع أنحاء العالم باستكشاف هذه التكنولوجيا والبناء عليها.