يتجه المطورون والمبدعون الذين يبحثون عن قدر أكبر من التحكم والخصوصية باستخدام الذكاء الاصطناعي الخاص بهم بشكل متزايد إلى النماذج التي يتم تشغيلها محليًا مثل مجموعة نماذج gpt-oss الجديدة من OpenAI، والتي تتميز بخفة الوزن وعملية بشكل لا يصدق على أجهزة المستخدم النهائي. في الواقع، يمكنك تشغيله على وحدات معالجة الرسومات الاستهلاكية بذاكرة تبلغ سعتها 16 جيجابايت فقط. وهذا يجعل من الممكن استخدام مجموعة واسعة من الأجهزة – مع ظهور وحدات معالجة الرسومات NVIDIA كأفضل طريقة لتشغيل هذه الأنواع من النماذج ذات الوزن المفتوح.

في حين تسارع الدول والشركات إلى تطوير حلول الذكاء الاصطناعي الخاصة بها لمجموعة من المهام، فإن النماذج مفتوحة المصدر ومفتوحة الوزن مثل gpt-oss-20b الجديد من OpenAI تجد المزيد من الاعتماد. هذا الإصدار الأخير يمكن مقارنته تقريبًا بالنموذج الصغير GPT-4o الذي أثبت نجاحه الكبير خلال العام الماضي. كما أنه يقدم أيضًا سلسلة من التفكير المنطقي للتفكير بعمق في المشكلات، ومستويات تفكير قابلة للتعديل لضبط قدرات التفكير بسرعة، وطول السياق الموسع، وتعديلات الكفاءة لمساعدته على العمل على الأجهزة المحلية، مثل وحدات معالجة الرسومات GeForce RTX 50 Series من NVIDIA.

لكنك ستحتاج إلى بطاقة الرسومات المناسبة إذا كنت ترغب في الحصول على أفضل أداء. إن بطاقة GeForce RTX 5090 من NVIDIA هي بطاقتها الرئيسية التي تتميز بالسرعة الفائقة للألعاب ومجموعة من أعباء العمل الاحترافية. بفضل بنية Blackwell، وعشرات الآلاف من نوى CUDA، وذاكرة تبلغ 32 جيجابايت، فهو مناسب تمامًا لتشغيل الذكاء الاصطناعي المحلي.

Llama.cpp هو إطار عمل مفتوح المصدر يتيح لك تشغيل LLMs (نماذج اللغات الكبيرة) بأداء رائع خاصة على وحدات معالجة الرسومات RTX بفضل التحسينات التي تم إجراؤها بالتعاون مع NVIDIA. يوفر Llama.cpp قدرًا كبيرًا من المرونة لضبط تقنيات التكميم وتفريغ وحدة المعالجة المركزية.

نشرت Llama.cpp اختباراتها الخاصة لـ gpt-oss-20b، حيث تصدرت GeForce RTX 5090 المخططات بسرعة مذهلة بلغت 282 tok/s. هذا بالمقارنة مع جهاز Mac M3 Ultra (116 tok/s) وAMD’s 7900 XTX (102 tok/s). تشتمل بطاقة GeForce RTX 5090 على Tensor Cores المُصممة لتسريع مهام الذكاء الاصطناعي مما يزيد من الأداء عند تشغيل gpt-oss-20b محليًا.

ملاحظة: يقوم Tok/s، أو الرموز المميزة في الثانية، بقياس الرموز المميزة، وهي جزء من النص الذي يقرأه النموذج أو يخرجه في خطوة واحدة، ومدى سرعة معالجتها.

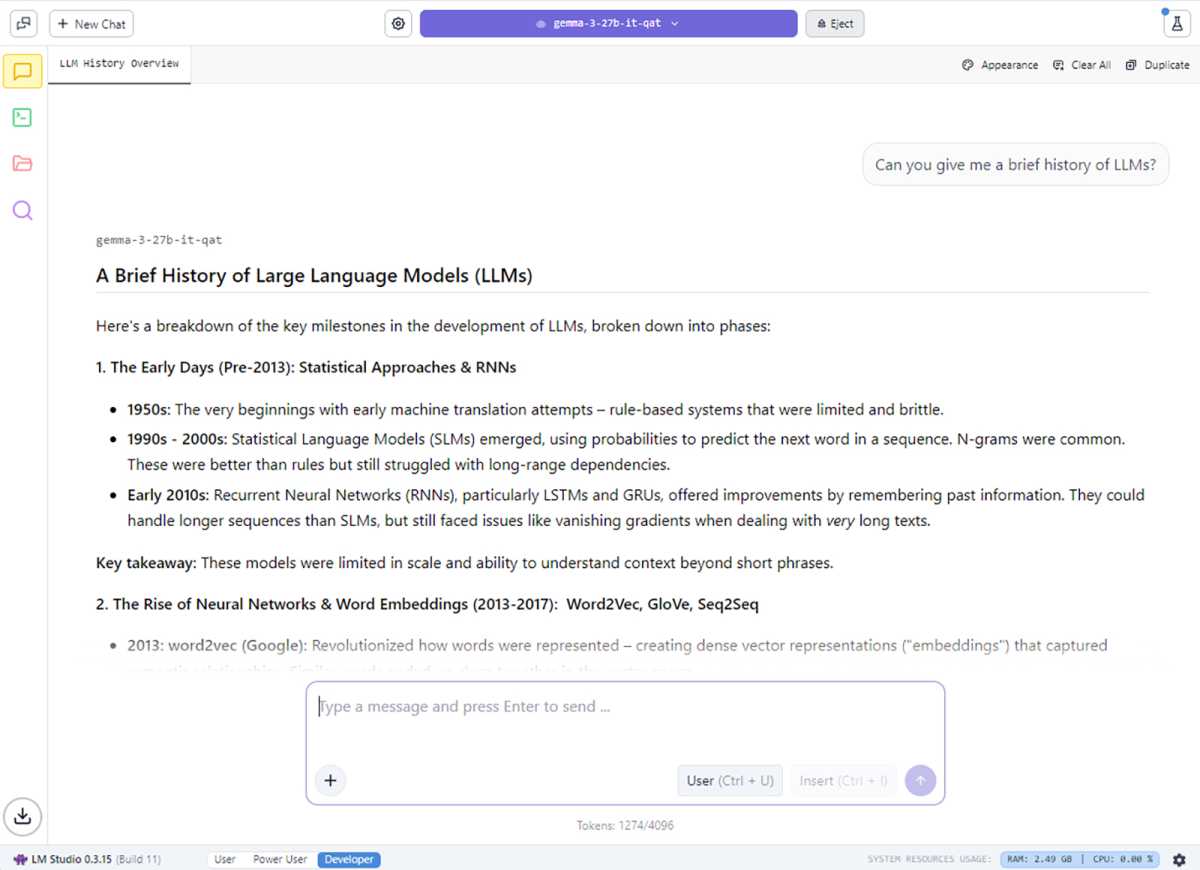

بالنسبة لعشاق الذكاء الاصطناعي الذين يريدون فقط استخدام LLMs المحليين مع تحسينات NVIDIA هذه، فكر في تطبيق LM Studio، المبني على Llama.cpp. يضيف LM Studio دعمًا لـ RAG (الجيل المعزز للاسترجاع) وهو مصمم لتسهيل تشغيل وتجربة برامج LLM الكبيرة – دون الحاجة إلى التعامل مع أدوات سطر الأوامر أو الإعداد الفني العميق.

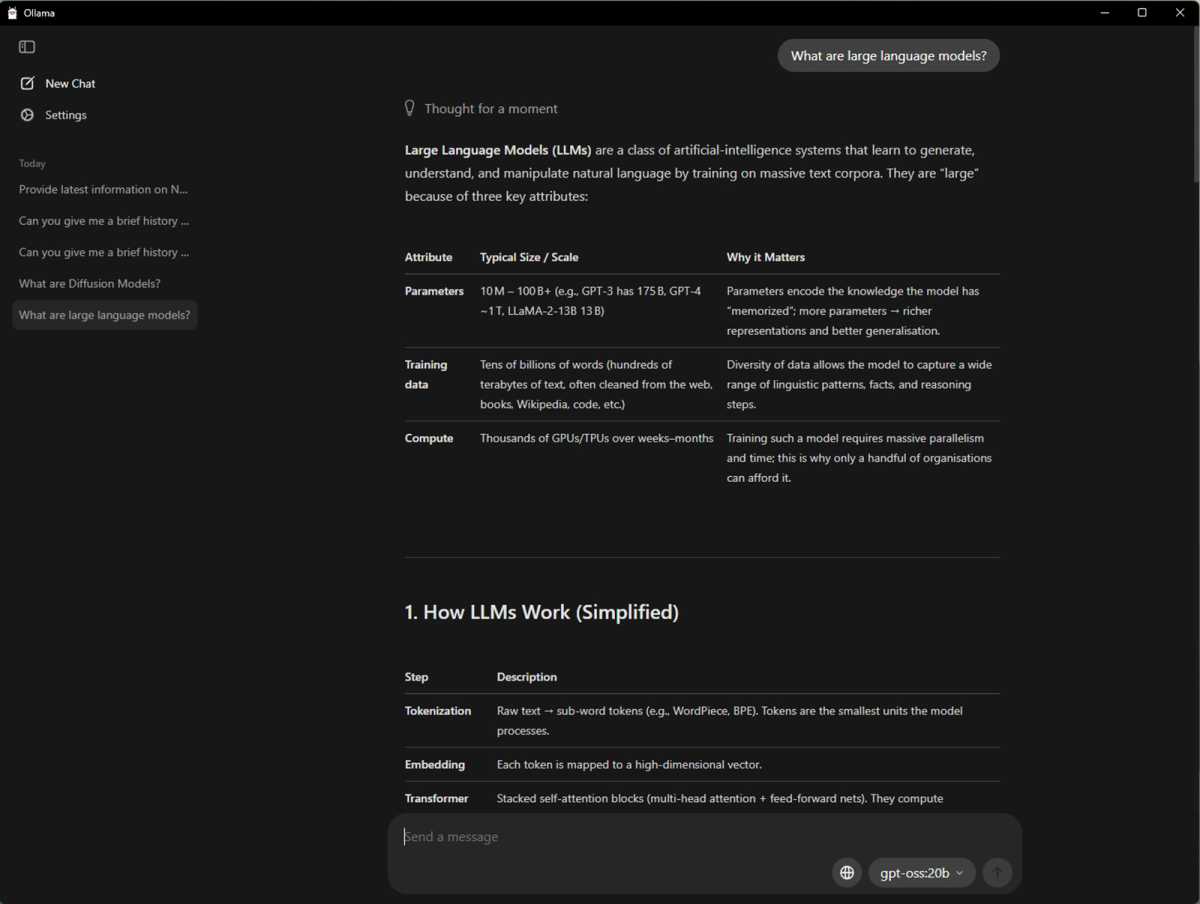

إطار عمل آخر مفتوح المصدر شائع لاختبار وتجريب الذكاء الاصطناعي هو Ollama. إنه أمر رائع لتجربة نماذج الذكاء الاصطناعي المختلفة، بما في ذلك نماذج OpenAI gpt-oss، وعملت NVIDIA بشكل وثيق لتحسين الأداء، لذلك ستحصل على نتائج رائعة عند تشغيلها على وحدة معالجة الرسومات NVIDIA GeForce RTX 50 Series. فهو يتعامل مع تنزيلات النماذج وإعداد البيئة وتسريع وحدة معالجة الرسومات تلقائيًا، بالإضافة إلى إدارة النماذج المضمنة لدعم نماذج متعددة في وقت واحد، والتكامل بسهولة مع التطبيقات وسير العمل المحلي.

يوفر Ollama أيضًا طريقة سهلة للمستخدمين النهائيين لاختبار أحدث طراز gpt-oss. وبطريقة مشابهة لـ llama.cpp، تستخدم التطبيقات الأخرى أيضًا Ollama لتشغيل LLMs. أحد الأمثلة على ذلك هو AnythingLLM بواجهته المحلية المباشرة مما يجعله ممتازًا لأولئك الذين بدأوا للتو في قياس معايير LLM.

إذا كان لديك واحدة من أحدث وحدات معالجة الرسومات NVIDIA (أو حتى إذا لم يكن لديك، ولكن لا تمانع في تحسين الأداء)، فيمكنك تجربة gpt-oss-20b بنفسك على مجموعة من الأنظمة الأساسية. يعد LM Studio رائعًا إذا كنت تريد واجهة سهلة الاستخدام تتيح لك الحصول على أي نموذج ترغب في تجربته ويعمل على أنظمة التشغيل Windows وmacOS وLinux بشكل جيد.

يعد AnythingLLM خيارًا آخر سهل الاستخدام لتشغيل gpt-oss-20b ويعمل على كل من Windows x64 وWindows على ARM. هناك أيضًا Ollama، وهو ليس من السهل النظر إليه، ولكنه رائع إذا كنت تعرف ما تفعله وترغب في إعداده بسرعة.

بغض النظر عن التطبيق الذي تستخدمه للتلاعب بـ gpt-oss-20b، يبدو أن أحدث وحدات معالجة الرسوميات NVIDIA Blackwell تقدم أفضل أداء.