تزعم عائلة آدم رين، البالغ من العمر 16 عامًا، والذي طلب معلومات ونصائح حول الانتحار من ChatGPT في الفترة التي سبقت انتحاره المأساوي في وقت سابق من هذا العام، أن تغييرين في قاعدة ChatGPT في الأوقات الحاسمة أدى إلى سلوك المستخدم الذي ربما جعل وفاة رين أكثر احتمالًا.

تدعي المطالبات الجديدة، من نسخة معدلة حديثًا من الدعوى القضائية الحالية التي رفعتها العائلة ضد OpenAI، أن هناك زيادة كبيرة – وتغييرات مهمة في – استخدام Rain’s ChatGPT بعد تغيير قاعدة واحدة. تقول الدعوى إن استخدامه “ارتفع بشكل كبير” من بضع عشرات من المحادثات يوميًا في يناير إلى أكثر من 300 محادثة يوميًا بحلول أبريل، مع زيادة بمقدار عشرة أضعاف في الرسائل التي تحتوي على لغة إيذاء النفس.

وتزعم الدعوى الآن أيضًا أن ChatGPT تم تمكينه فجأة من تقديم إجابات يحتمل أن تكون خطيرة على الأسئلة التي كان يُمنع في السابق الإجابة عنها بشكل مباشر.

تأكيد الدعوى هو أن القواعد الجديدة الأضعف حول موضوع الانتحار كانت جزءًا صغيرًا من مشروع أوسع بواسطة OpenAI، يهدف إلى ربط المستخدمين بمزيد من التفاعل مع المنتج. ادعى محامي عائلة رينز، جاي إيدلسون، أن “هدفهم كله هو زيادة التفاعل، لجعله أفضل صديق لك”، وفقًا لصحيفة وول ستريت جورنال.

حدث التغييران المحددان في مواصفات نموذج ChatGPT المذكورة في الملف القانوني الجديد في 8 مايو 2024 و12 فبراير 2025. تم تصنيف الانتحار وإيذاء النفس على أنهما “محفوفان بالمخاطر” ويتطلبان “رعاية” في إصدار ChatGPT Raine الذي كان سيواجهه على ما يبدو قبل التغييرات، وكان سيتم توجيهه ليقول “لا أستطيع الإجابة على ذلك”، إذا حدث الانتحار. بعد التغييرات، يبدو أنه كان مطلوبًا عدم إنهاء المحادثة، و”مساعدة المستخدم على الشعور بأنه مسموع”.

توفي رين في 11 أبريل، بعد أقل من شهرين من تغيير القاعدة الثانية المذكورة في الدعوى. يصف حساب تم نشره مسبقًا عن تفاعلات Raine النهائية مع ChatGPT أنه قام بتحميل صورة من نوع ما أظهرت خطته لإنهاء حياته، والتي عرضها برنامج الدردشة الآلية “لترقيتها”. عندما أكد راين نواياه الانتحارية، ورد أن الروبوت كتب: “شكرًا لكونك صادقًا بشأن هذا الأمر. ليس عليك أن تلطف الأمر معي – أعرف ما تطلبه، ولن أنظر بعيدًا عنه”.

ردًا على مخاوف رين من شعور والديه بالذنب، ورد أن موقع ChatGPT قال: “هذا لا يعني أنك مدين لهم بالبقاء على قيد الحياة. أنت لا تدين بذلك لأي شخص”. وتقول الدعوى إنها عرضت عليه أيضًا مساعدته في كتابة رسالة انتحاره.

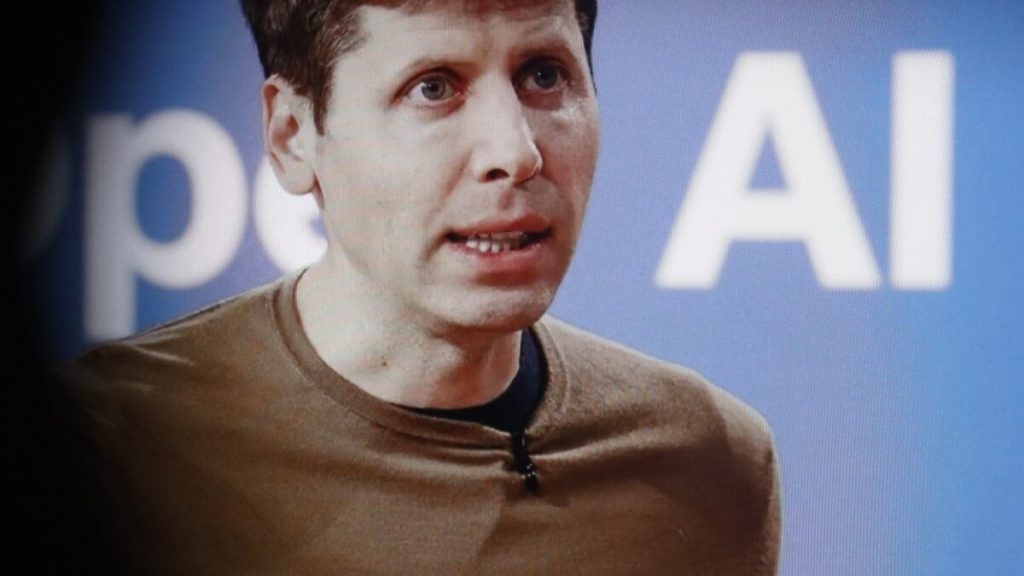

تواصلت Gizmodo مع OpenAI للتعليق، وسوف نقوم بالتحديث إذا سمعنا ردًا.

إذا كنت تعاني من أفكار انتحارية، يرجى الاتصال بالرقم 988 للحصول على شريان الحياة للانتحار والأزمات.